1

Uno de los eventos más importantes en la historia de la filosofía de la ciencia —en otras palabras, el Federer vs Nadal, o el Madrid vs Barcelona del pensamiento científico— ocurrió en 1965: el famoso debate entre Popper y Kuhn. Mientras el primero sostenía que la ciencia avanza descartando hipótesis falsas mediante pruebas rigurosas, el segundo afirmaba que los grandes cambios ocurren cuando se acumulan anomalías que ya no encajan en el paradigma dominante, forzando a cambiar las reglas del juego. Ese viejo desacuerdo, en medicina, tiene que ver con el modo en que evaluamos la evidencia y decidimos qué tratamientos “funcionan”.

En psiquiatría tiene que ver con la discrepancia, muchas veces, de la clínica con la evidencia.

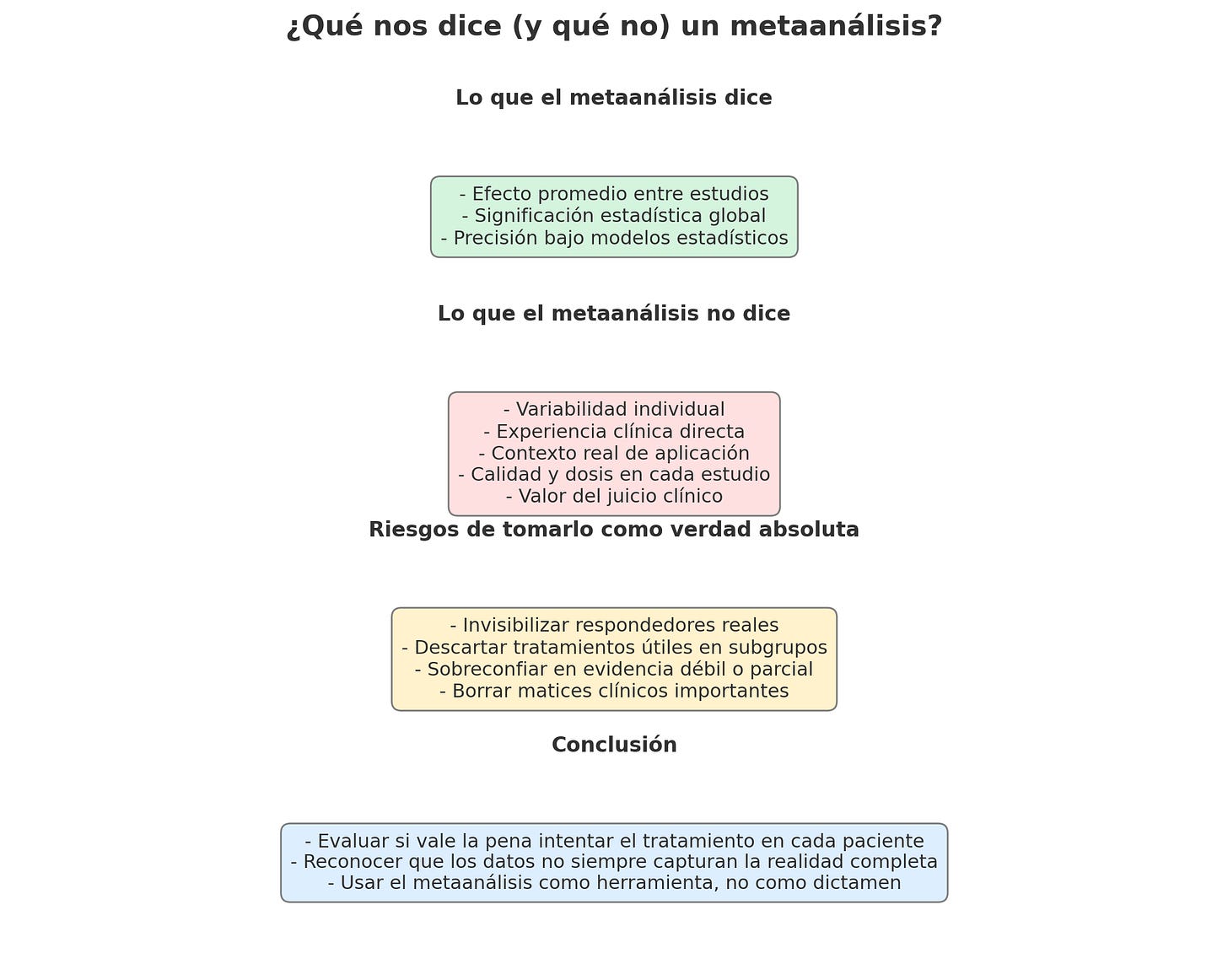

El metaanálisis, considerado la cúspide de la evidencia científica, sintetiza resultados de múltiples estudios para obtener un "promedio" estadístico. Pero, ¿qué ocurre cuando ese promedio no refleja la experiencia clínica? ¿Y si, en su afán de generalizar, el metaanálisis silencia precisamente los casos en que los tratamientos funcionan? Tal vez hemos llegado al punto en que las anomalías ya no pueden ignorarse.

Este no es un debate puramente teórico; es práctico en la manera como leemos evidencia que discrepa entre el resultado estadístico y la práctica clínica. Para profundizar esta idea, leer acá. Recientemente me topé con un estudio publicado en Lancet, que sostiene que la clozapina no es claramente superior a otros antipsicóticos de segunda generación en casos de esquizofrenia resistente. Este estudio me recordó a otro de 2018, el de Cipriani et al., que afirmaba que los antidepresivos superaban sin dudas al placebo. Ambos trabajos muestran que la estadística puede decir una cosa, mientras la experiencia clínica insiste en otra.

2

CIPRIANI Y EL CASO DE LOS ANTIDEPRESIVOS

Los estudios más sólidos muestran que el efecto de los antidepresivos sobre la depresión tiene un tamaño aproximado de 0.3. Técnicamente, esto significa que la mejoría en quienes reciben el antidepresivo es apenas un tercio de una desviación estándar mayor que en quienes reciben placebo. En otras palabras: el efecto existe, pero es más modesto de lo que muchos suponían. Lo suficiente para alcanzar significación estadística, pero no necesariamente para convencer a quienes buscan un impacto clínico claro y generalizado.

Ahora bien, ¿Qué vemos en la práctica?, pacientes que en general responden a los antidepresivos, pero esa respuesta suele variar más de lo esperado, en este punto siempre alecciono a los residentes a que repasemos que tan bien esta funcionando el tratamiento, porque el sesgo de confirmación, suele ser una droga peligrosa, es decir:

A veces, los psiquiatras vemos lo que queremos ver. Tendemos a recordar los casos en los que el antidepresivo funcionó, y a olvidar o reinterpretar aquellos en los que no lo hizo. Este sesgo de confirmación es más común de lo que creemos. Además, hay factores clínicos que pueden engañarnos: muchas veces, el curso natural de la enfermedad ya estaba entrando en fase de mejoría cuando iniciamos el tratamiento; no es raro que los pacientes consulten justo en el pico de los síntomas, antes de que empiecen a mejorar espontáneamente. En otros casos, la primera relación terapéutica en sí —la contención, la escucha, la presencia— puede tener un efecto más decisivo que el fármaco. Y a veces, simplemente, el deseo de que algo funcione nos nubla el juicio: necesitamos que el tratamiento funcione, y eso basta para convencernos de que lo hizo.

Entonces, ese efecto clínico, evidenciado en los metanálisis, que parece pequeño, suele chocar con nuestra práctica donde parece mayor. Esta disonancia entre la evidencia y la experiencia clínica plantea la siguiente pregunta: ¿es posible que los estudios estén diciendo la verdad… pero no toda la verdad?

Un posible escenario es que, como suelen sugerir algunos autores, no tratamos un trastorno depresivo mayor, sino un subtipo de este. Otra posibilidad, la más plausible, es que el efecto promedio encubra una gran variabilidad individual. Si un tercio de los pacientes exhibe una respuesta positiva, mientras que los otros dos tercios no exhiben respuesta alguna, el promedio se diluye, transformando lo que se consideraba una recuperación para algunos en una cifra insignificante para todos. Por lo tanto, el problema no radica en la eficacia vs ineficacia de los antidepresivos, sino en su funcionamiento desigual en sub-grupos de pacientes, y el análisis estadístico del metanálisis no está concebido para capturar dicha desigualdad y heterogeneidad.

3

SCHNEIDER-THOMA Y EL CASO DE LA CLOZAPINA

Un segundo ejemplo es un estudio publicado este año en The Lancet Psychiatry, a cargo de Schneider-Thoma et al., un metaanálisis a gran escala que concluye:

“El metaanálisis no proporcionó evidencia que respalde el uso preferencial de clozapina en la esquizofrenia resistente al tratamiento.”

Una afirmación de ese tipo obliga a preguntarse. ¿Cómo puede ser que un tratamiento profundamente recomendado en nuestra práctica —la convicción de que la clozapina es el mejor recurso en los casos resistentes de esquizofrenia— no logre demostrar su superioridad en los datos?

El estudio es una revisión sistemática y metaanálisis de datos individuales (IPD) que comparó la eficacia de la clozapina con otros antipsicóticos de segunda generación en esquizofrenia resistente. Analizó 19 estudios con un total de 1599 participantes, aunque solo se obtuvo IPD para 12 de ellos. El análisis encontró:

…una ventaja pequeña e incierta a favor de otros antipsicóticos, principalmente olanzapina y risperidona, y concluyó que no se puede afirmar la superioridad de la clozapina. La confianza en la evidencia fue calificada como muy baja.

Desde una perspectiva técnica, el resultado es válido. Sin embargo, desde una perspectiva clínica, resulta desconcertante, dado que entra en conflicto directo con la experiencia acumulada y años de investigación, desde los trabajos pioneros de John Kane en la década de 1980 hasta numerosas observaciones longitudinales que han consolidado su estatus como el estándar de oro en esta población. Dicha evidencia condujo a que la mayoría de las directrices clínicas la aconsejan como la primera alternativa cuando han fallado al menos dos fármacos antipsicóticos previos. Por lo tanto, ¿cómo se justifica que, al atravesar el filtro del metaanálisis, esa aparente superioridad se diluya?

Parte de la respuesta puede estar en los detalles metodológicos. La dosis de clozapina en los ensayos fue más baja que la usada habitualmente en la práctica. No se reportaron niveles plasmáticos, esenciales para saber si el tratamiento fue realmente eficaz. Se rellenaron datos faltantes bajo modelos que, aunque estadísticamente razonables, fabrican valores donde no los hubo. Se utilizó una escala (BPRS) menos sensible que la PANSS, ampliamente aceptada como referencia.

El aspecto llamativo, sin embargo, no radica únicamente en los hallazgos del estudio, sino también en lo que el instrumento revela sobre sí mismo y sobre diversos metaanálisis, esto es:

Los metaanálisis persisten como un instrumento de síntesis que aglutina todos los errores, omisiones y decisiones de los estudios que lo integran. Se trata, en términos precisos, de una observación basada en la acumulación. El resultado final se presenta como una media: un número claro que tranquiliza, pero que puede eliminar las historias clínicas que no se alinean.

Aunque los resultados de este metaanálisis son sugerentes, más sugerente aún es lo que no logra captar: la potencia clínica de la clozapina cuando se usa con las dosis adecuadas, el monitoreo necesario y en los pacientes correctos. Por ello, más allá del metanálisis, y hasta que una mejor evidencia diga lo contrario, la clozapina sigue siendo el gold standard para la esquizofrenia resistente al tratamiento.

4

CONCLUSIÓN

El debate entre Popper y Kuhn no tuvo ganador; sin embargo, ambos adquirieron conocimientos mutuos, lo que los condujo a enfrentar la ambigüedad inherente a sus respectivas teorías. Algo similar ocurre con los metaanálisis: nos dicen algo valioso, pero no lo dicen todo. En lugar de cuestionarnos si un tratamiento "funciona en promedio", podríamos plantearnos si vale la pena probarlo en cada paciente, sabiendo que en algunos casos puede marcar una diferencia real y profunda. El problema no radica en si un resultado es "falso", sino en si efectivamente está capturando lo que necesitamos saber. Puesto que, cuando reducimos la eficacia a un solo número, corremos el riesgo de borrar lo que más importa: los matices clínicos, la individualidad del paciente y aquello que no siempre sobrevive al embudo metanalítico, pero que sí aparece en la práctica real.

El metaanálisis tiene su lugar, claro. Pero cuando se vuelve ciego a lo que importa, cuando reduce lo clínico a lo computable, uno solo puede mirar al promedio y decir: metaanalízame esta!!.